随着深度学习,特别是超大规模预训练模型技术的发展,模型训练和推理所消耗的能源日益增长,这带来了更多的碳排放问题,对于全球气候可能造成不良影响。为了解决这一问题,研究者们开始探索研发更为绿色的AI算法及其相关技术。

1.绿色AI指的是在不增加,甚至降低计算成本的前提下,研发性能更为强大的AI模型的技术手段。

2.实现GreenAI主要有两个方面的手段,一是设定评价模型能效的方法;二是在模型架构、训练、推理、数据利用等方面进行研究。

绿色AI指的是在不增加,甚至降低计算成本的前提下,研发性能更为强大的AI模型的技术手段。[1] 绿色AI的概念最早由艾伦人工智能研究院等机构的研究者在2020年提出。

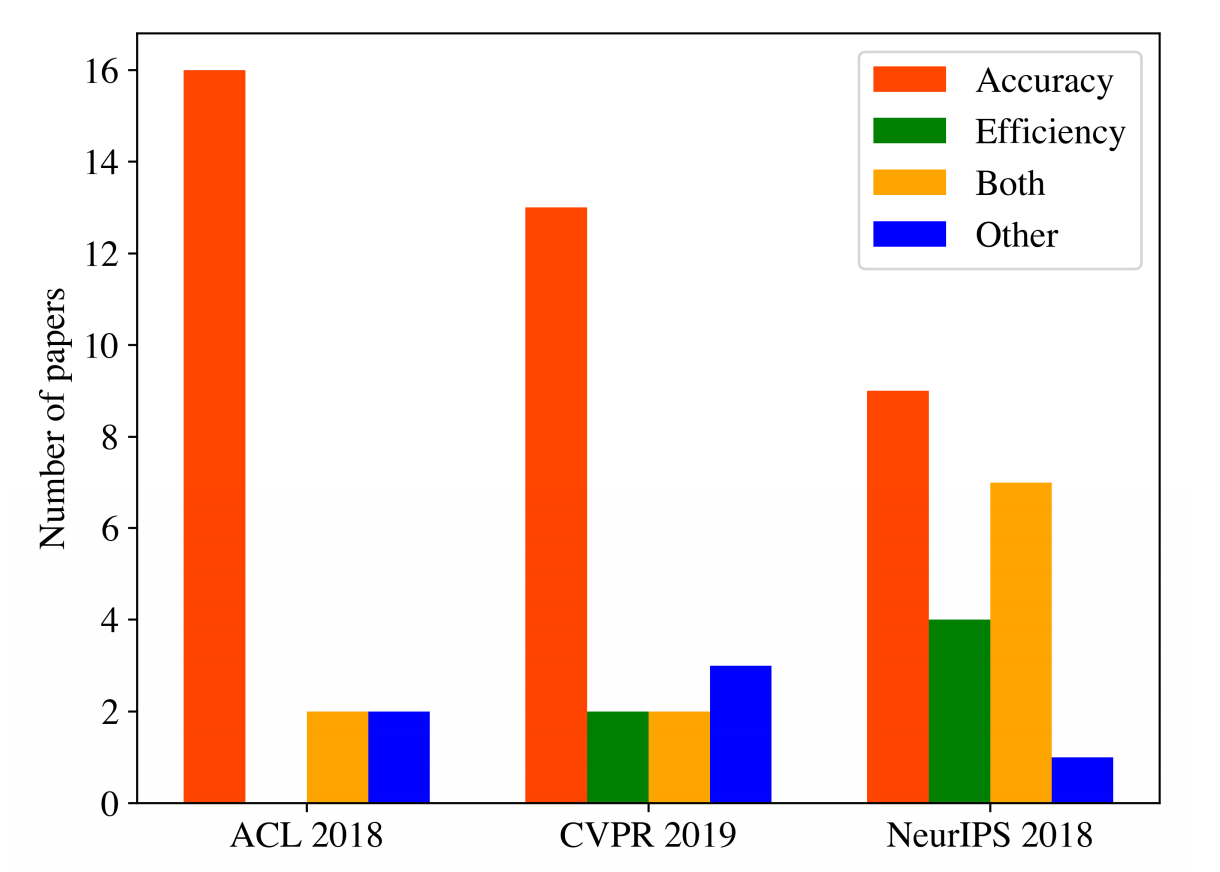

提出绿色AI概念的目的在于呼吁AI研究者重视人工智能带来的环境和可持续发展问题。据[2]统计,2018-2019年的国际顶会中,很多研究者关注AI的准确率而非效率。

图注:顶会中研究者关注准确率、效率和二者兼有的比例 [2]

相对于绿色AI概念的是红色AI,指的是不计算力代价提升模型性能的技术和模型。[1] 与红色AI不同,绿色AI鼓励研究者尽可能减少模型训练和推理所消耗的算力资源。

2020年的绿色AI论文中,研究者认为实现绿色AI的首要工作是确定评价AI能耗的方法。[2] 在评价模型的效率的指标方面,包括:

(1)碳排放量

(2)电力消耗

(3)实时收敛时间

(4)参数规模

(5)浮点运算量(即达到预期效果所消耗的算力)

图注:计算红色AI的公式[3]

此外,有开源社区开发者提出了绿色AI标准,推动研究者上传评测结果,推动建立统一的能效评价体系。[4]

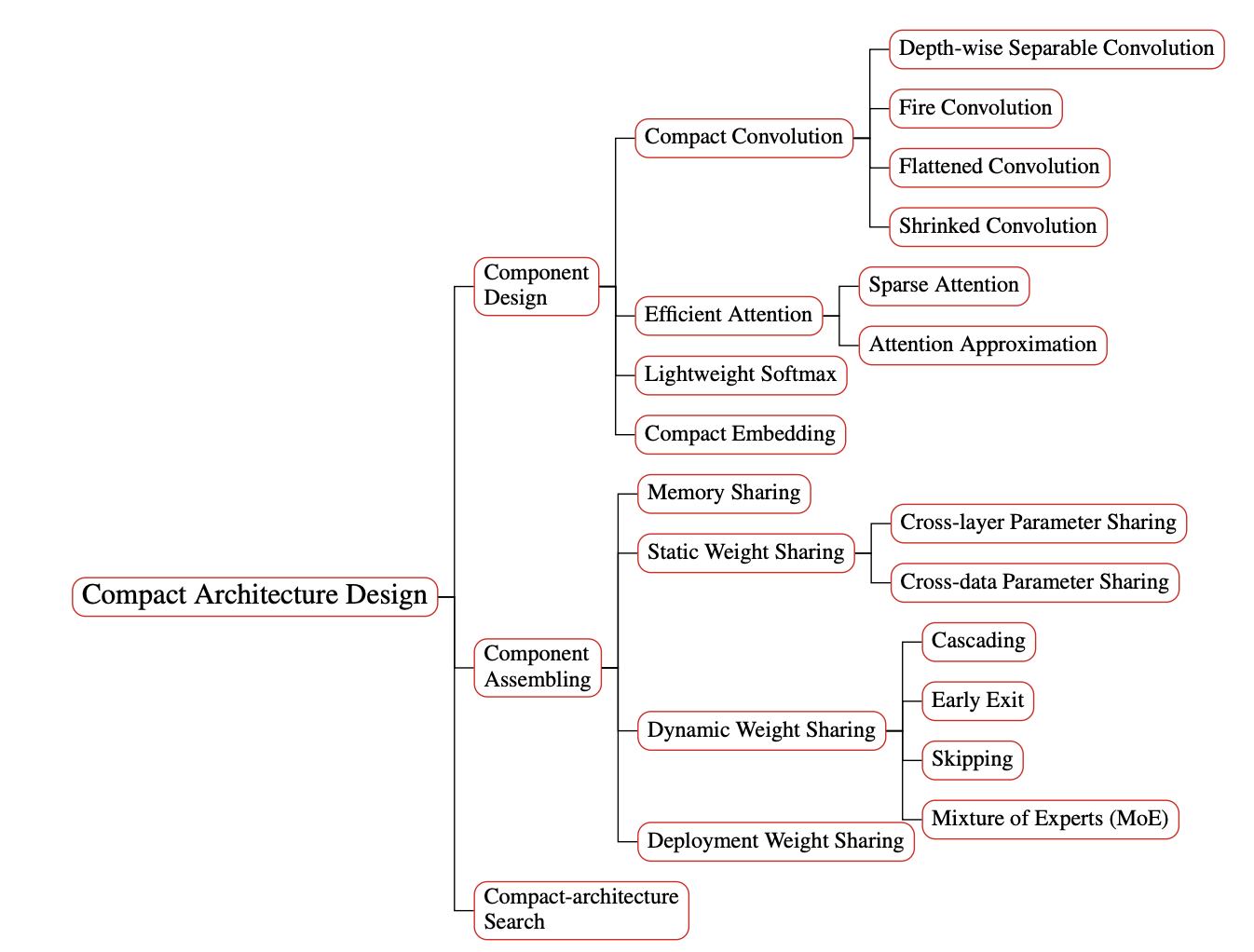

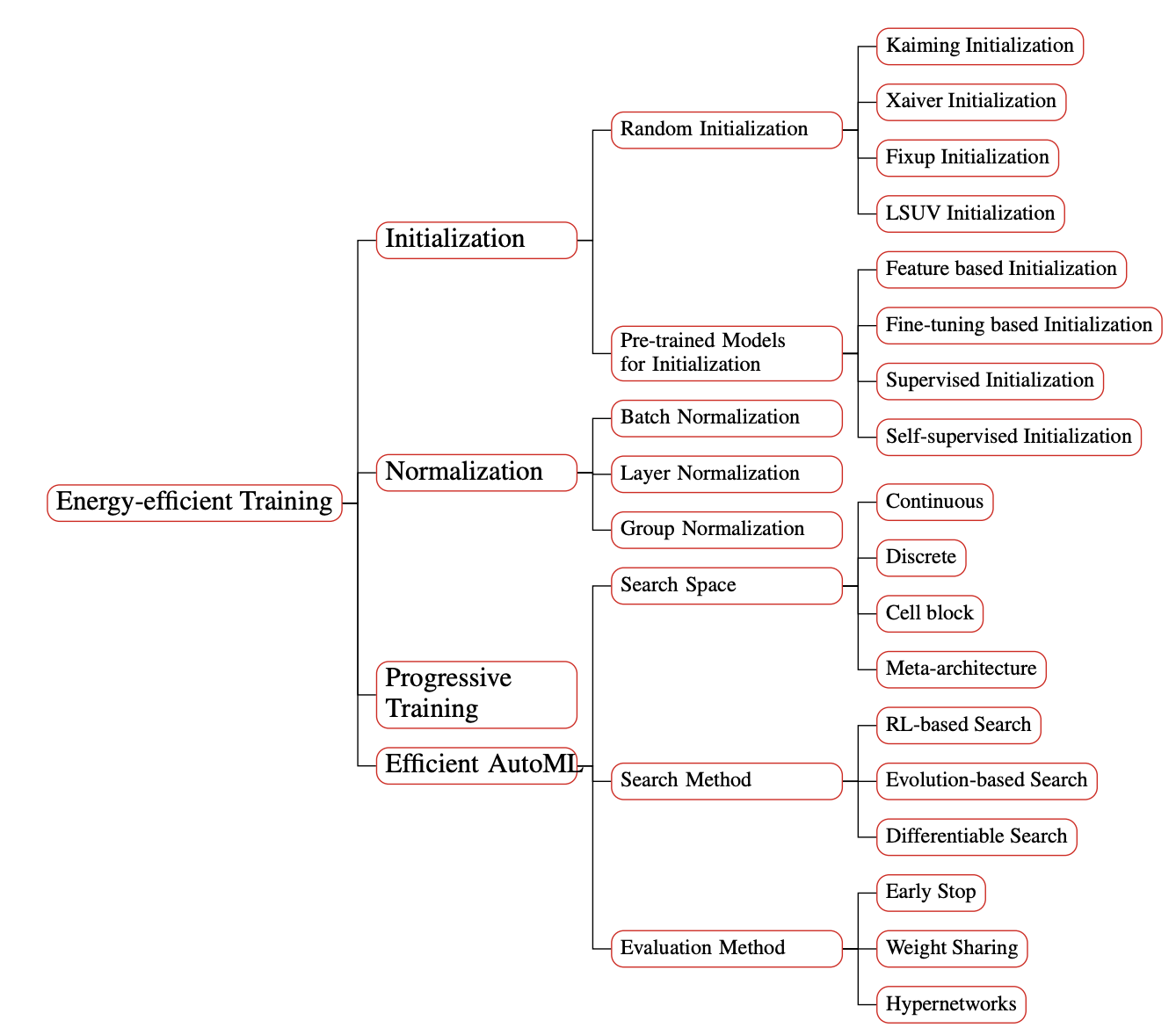

在[1]中,研究者认为应当在模型架构、训练方法、推理方法和数据使用等方面进行改进。主要包括:

(1)紧凑的模型架构:在更小规模的模型上实现更高性能;

(2)高效的训练策略:在初始化、正则化、渐进式训练、高效自动机器学习(AutoML)等方面进行技术改进;

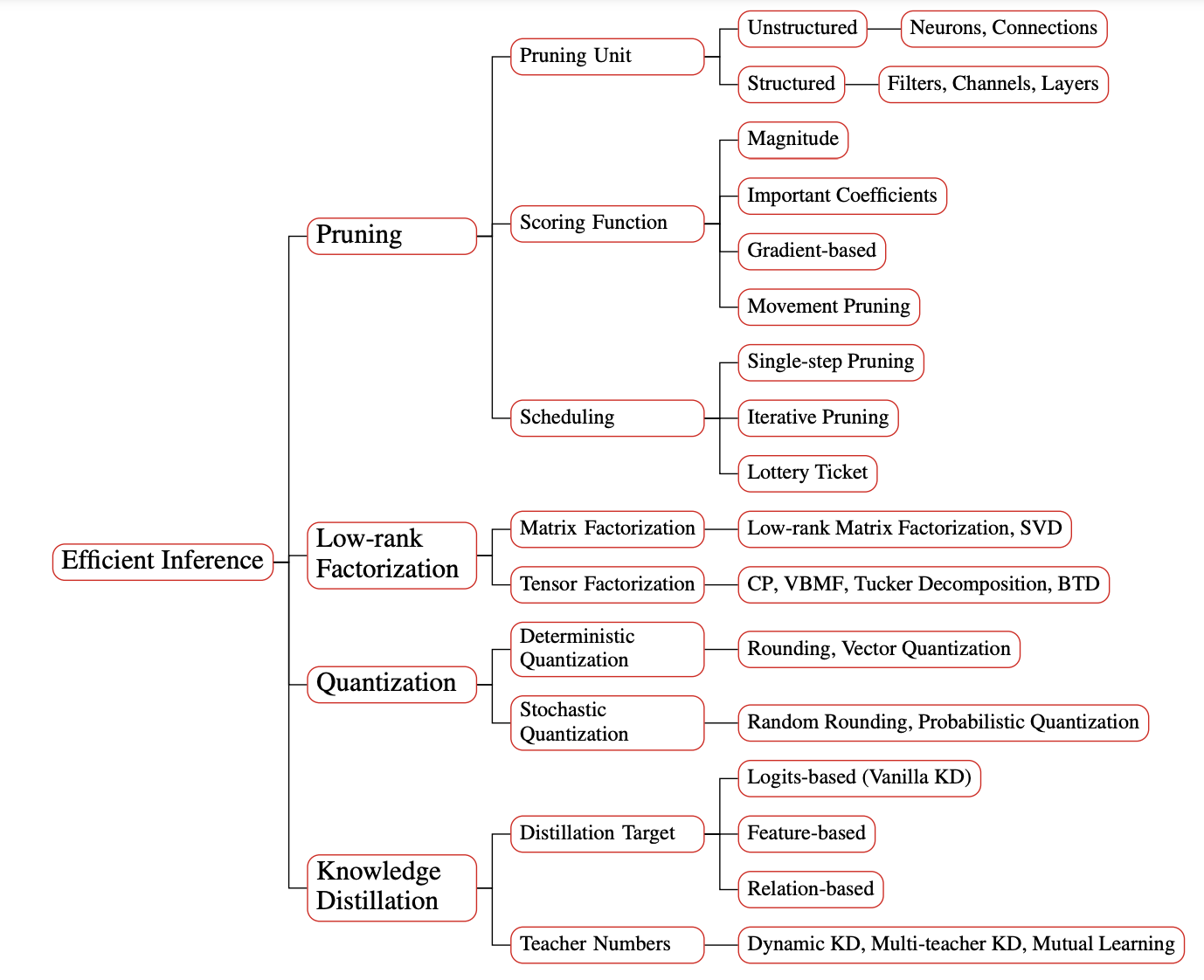

(3)高效推理策略:包括模型剪枝、蒸馏、低阶因式分解、数量化等;

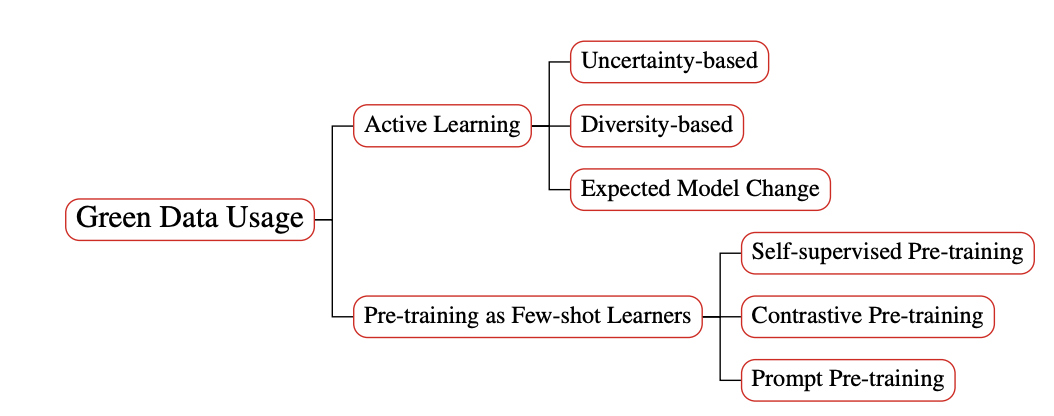

(4)高效数据利用:包括主动学习和小样本学习等。

[1] Xu, Jingjing, et al. "A Survey on Green Deep Learning." arXiv preprint arXiv:2111.05193 (2021).

[2] Schwartz, Roy, et al. "Green ai." Communications of the ACM 63.12 (2020): 54-63.

[3] Green AI:https://cacm.acm.org/magazines/2020/12/248800-green-ai/fulltext

[4] Green Artificial Intelligence Standard:https://github.com/daviddao/green-ai

文章来源:智源社区AI FrontPage

3 个月前

阿西洛马人工智能原则(Asilomar AI Principles)是一套旨在确保人工智能(AI)技术安全、伦理和有益发展的指导原则。该原则于2017年1月在美国加利福尼亚州阿西洛马举行的“Beneficial AI”会议上提出,由“生命未来研究所”(Future of Life Institute)牵头制定,得到了包括斯蒂芬·霍金、埃隆·马斯克等在内的众多AI领域专家和学者的支持。 原则概述 阿西洛马人工智能原则共包含23条,分为三大类:科研问题、伦理和价值、更长期的问题。以下是各类别的核心内容: 1. 科研问题(Research Issues) 研究目标:AI研究应致力于创造有益于人类的智能,而非不受控制的智能。 研究经费:AI投资应部分用于研究如何确保其有益使用,包括计算机科学、经济学、法律、伦理等领域的问题。 科学与政策的联系:AI研究者与政策制定者之间应保持建设性交流。 科研文化:应培养合作、信任与透明的科研文化,避免因竞争而降低安全标准。 2. 伦理和价值(Ethics and Values) 安全性:AI系统应在整个生命周期内保持安全可靠,并在可行的情况下接受验证。 故障透明性:若AI系统造成损害,应能确定其原因。 责任:AI设计者和建造者应对其使用、误用及行为产生的道德影响负责。 价值归属:高度自主的AI系统应确保其目标与人类价值观一致。 个人隐私:人们应有权访问、管理和控制其生成的数据。 共同繁荣:AI创造的经济繁荣应惠及全人类。 3. 更长期的问题(Longer-term Issues) 能力警惕:应避免对未来AI能力上限的过高假设。 风险:AI系统可能带来的灾难性或存亡风险,需有针对性地减轻。 递归的自我提升:能够自我升级或复制的AI系统需受严格的安全控制。 公共利益:超级智能的开发应服务于广泛认可的伦理观念,而非单一国家或组织的利益。 原则的意义与影响 阿西洛马人工智能原则旨在为AI技术的发展提供伦理框架,确保其符合人类利益并避免潜在风险。这些原则不仅得到了学术界的广泛支持,也在政策制定和行业实践中产生了深远影响。 争议与挑战 尽管原则提出了明确的指导方向,但在实际应用中仍面临诸多挑战。例如,如何确保AI系统的价值归属与人类价值观一致,以及如何在全球范围内协调AI技术的监管等问题。 总结 阿西洛马人工智能原则为AI技术的发展提供了重要的伦理和安全指导,但其成功实施仍需全球范围内的合作与努力。如需了解更多细节,可参考相关文献或访问生命未来研究所的官方网站。

11 个月前

绿色AI指的是在不增加,甚至降低计算成本的前提下,研发性能更为强大的AI模型的技术手段。

Minimax(海螺AI)已由大模型名Minimax替换原海螺AI。现海螺AI为Minimax视频生成产品名。

海螺AI