一种全新的大语言模型(LLM)架构有望代替至今在 AI 领域如日中天的 Transformer,性能也比 Mamba 更好。2024年7月8日,有关 Test-Time Training(TTT)的论文成为了人工智能社区热议的话题。

斯坦福大学、加州大学伯克利分校、加州大学圣地亚哥分校和Meta的学者提出了一种全新架构,希望能用机器学习模型取代RNN的隐藏状态。这个架构通过对输入token进行梯度下降来压缩上下文,被称为“测试时间训练层(Test-Time-Training layers,简称TTT层)”。“共同一作”加州大学伯克利分校的Karen Dalal表示,我相信这将从根本上改变语言模型。

在机器学习模型中,TTT 层直接取代 Attention,并通过表达性记忆解锁线性复杂性架构,使我们能够在上下文中训练具有数百万(有时是数十亿)个 token 的 LLM。

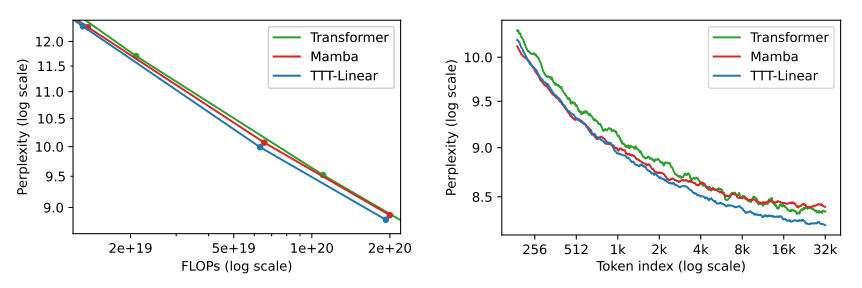

在 125M 到 1.3B 参数规模的大模型上进行了一系列对比发现,TTT-Linear 和 TTT-MLP 均能匹敌或击败最强大的 Transformers 和 Mamba 架构方法。

TTT 层作为一种新的信息压缩和模型记忆机制,可以简单地直接替代 Transformer 中的自注意力层。

过去这些年来,对大模型的研究和理解都绕不开“循环神经网络(RNN)”。RNN是一种深度学习模型,由许多相互连接的组件组成,经过训练后可以处理顺序数据输入并将其转换为特定的顺序数据输出,例如将文本从一种语言翻译成另一种语言。顺序数据是指单词、句子或时间序列数据之类的数据,其中的顺序分量根据复杂的语义和语法规则相互关联。

而“隐藏状态”是RNN模型中的一个关键概念。它可以看作是网络在每个时间步骤上的“记忆”,存储了之前时间步骤中的信息,并通过时间在不同步骤之间传递。隐藏状态可以捕捉到序列中的长期依赖性,从而使模型能够理解整个序列的上下文。

在传统的RNN中,隐藏状态的固定大小表达能力受限,也不好并行训练。例如,像Mamba这样的RNN层,会随着时间的推移压缩成一个固定大小的状态,它们虽然效率很高,但性能受限于其表达能力。

这个研究团队的对TTT层的想法来自于:与其让RNN隐藏状态被动地储存信息,不如让它主动学习。**设计的“TTT层”突破了“RNN层”在长上下文中性能受限的问题。**

他们在1.25亿~ 13亿个参数规模的大模型上进行一系列的对比后发现,TTT-Linear(线性模型)和TTT-MLP (MLP为多层感知器,基于前馈神经网络的深度学习模型)均能匹敌或击败最强大的Transformers和 Mamba架构方法。

隐藏状态时线性模型的TTT-Linear表现超过了Transformer和Mamba,用更少的算力达到更低的困惑度(下图左),也能更好利用长上下文(下图右)。此外,隐藏状态时MLP模型的TTT-MLP在32k长上下文时表现还要更好。

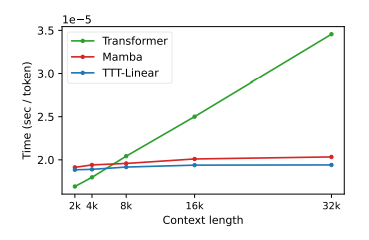

在实际运行时间上,TTT模型也比Transformer和Mamba更快。

更多详细内容,可参见[https://arxiv.org/abs/2407.04620]

16 小时前

命令优先,而非图形界面。

26 天前

这正是当前 AI 视频生成领域最前沿的突破方向。你提出的这个问题,本质上是在问如何让 AI 从“画皮”进阶到“画骨”——即不仅画面好看,运动逻辑也要符合现实世界的物理法则。 结合最新的技术进展(如 2025 年的相关研究),要让 AI 生成符合真实规律的视频,我们可以通过以下几种“高级语言描述法”来与模型沟通: 1. 使用“力提示”技术:像导演一样指挥物理力 🎬 这是谷歌 DeepMind 等团队提出的一种非常直观的方法。你不需要懂复杂的物理公式,只需要在提示词中描述“力”的存在。 描述力的方向与强度: 你可以直接告诉 AI 视频中存在某种力。例如,不只是写“旗帜飘动”,而是写“旗帜在强风中剧烈飘动”或“气球被轻轻向上吹起”。 区分全局力与局部力: 全局力(风、重力): 影响整个画面。例如:“Global wind force blowing from left to right”(从左到右的全局风力)。 局部力(碰撞、推力): 影响特定点。例如:“A ball rolling after being kicked”(球被踢后滚动)。 效果: AI 模型(如 CogVideoX 结合特定模块)能理解这些力的矢量场,从而生成符合动力学的运动,比如轻的物体被吹得更远,重的物体移动缓慢。 2. 调用“思维链”与物理常识:让 LLM 当质检员 🧠 有时候直接描述很难精准,我们可以借助大型语言模型(LLM)作为“中间人”来审核物理逻辑。这种方法(如匹兹堡大学的 PhyT2V)利用 LLM 的推理能力。 分步描述(Chain-of-Thought): 你可以在提示词中要求 AI “思考过程”。例如,不只是生成“水倒入杯子”,而是引导它:“首先,水从壶嘴流出,形成抛物线;然后,水撞击杯底,产生涟漪;最后,水位上升,流速减慢。” 明确物理规则: 在提示词中直接嵌入物理常识。例如:“根据重力加速度,球下落的速度应该越来越快”或“流体具有粘性,流动时会有拉丝效果”。 回溯修正: 如果第一版视频不符合物理规律(比如球浮在空中),你可以通过反馈指令让系统进行“回溯推理”,识别出视频与物理规则的语义不匹配,并自动修正提示词重新生成。 3. 参数化控制:像物理老师一样给定数值 📏 如果你需要极其精确的物理运动(例如做科学实验模拟或电影特效),可以使用类似普渡大学 NewtonGen 框架的思路,直接给定物理参数。 设定初始状态: 在语言描述中包含具体的物理量。 位置与速度: “一个小球从坐标 (0, 10) 以初速度 5m/s 水平抛出”。 角度与旋转: “一个陀螺以角速度 10rad/s 旋转”。 质量与材质: “一个轻质的泡沫块”与“一个沉重的铁球”在相同力作用下的反应是不同的。 指定运动类型: 明确指出是“匀速直线运动”、“抛物线运动”还是“圆周运动”。AI 会根据这些语义,调用内置的“神经物理引擎”来计算轨迹,确保视频中的物体运动轨迹符合牛顿定律。 4. 结合物理引擎的混合描述:虚实结合 🧩 更高级的方法是让语言描述直接驱动物理模拟器(如 Blender, Genesis),然后将结果渲染成视频。 描述物理属性: 在提示词中指定物体的密度、弹性系数、摩擦力等。 事件驱动描述: 描述物体间的相互作用。例如:“一个刚性的小球撞击一个柔软的布料,布料发生形变并包裹住小球”。 通用物理引擎: 像 Genesis 这样的新模型,允许你用自然语言描述复杂的物理场景(如“一滴水滑落”),它能直接生成符合流体动力学的模拟数据,而不仅仅是看起来像视频的图像帧。 📝 总结:如何写出“物理级”提示词? 为了更直观地掌握这种描述方式,这里总结了一个对比表: 一句话总结: 要用语言描述物理运动,关键在于将“视觉结果”转化为“物理过程”。多用描述力(风、推力)、属性(重力、粘性)、参数(速度、角度)的词汇,甚至直接告诉 AI 要遵循某种物理规律,这样生成的视频才会有真实的“重量感”和“真实感”。

28 天前

利用大语言模型(LLM)构建虚拟的“世界模型”(World Models),以此作为 KI 智能体(AI Agents)积累经验和训练的场所。 核心概念:让 LLM 成为 AI 的“模拟练习场” 目前,开发能在现实世界执行复杂任务的 AI 智能体(如机器人、自动化软件助手)面临一个巨大挑战:获取实际操作经验的成本极高且充满风险。 如果让机器人在物理世界中通过“试错”来学习,不仅效率低下,还可能造成硬件损毁。 研究人员提出的新思路是:利用已经掌握了海量人类知识的大语言模型(LLM),由它们通过文字或代码生成一个模拟的“世界模型”。 1. 什么是“世界模型”? 世界模型是一种模拟器,它能预测特定行为可能产生的结果。 传统方式: 需要开发者手动编写复杂的代码来定义物理法则和环境规则。 LLM 驱动方式: 预训练的大模型(如 GPT-4 或 Claude)已经具备了关于世界运行逻辑的知识(例如:知道“推倒杯子水会洒”)。研究人员可以利用 LLM 自动生成这些模拟环境的逻辑。 2. 研究的具体内容 来自上海交通大学、微软研究院、普林斯顿大学和爱丁堡大学的国际研究团队对此进行了深入研究。他们测试了 LLM 在不同环境下充当模拟器的能力: 家庭模拟(Household Simulations): 模拟洗碗、整理房间等日常任务。 电子商务网站(E-Commerce): 模拟购物行为、库存管理等逻辑。 3. 关键发现: 强结构化环境表现更佳: 在规则清晰、逻辑严密的场景(如简单的文本游戏或特定流程)中,LLM 驱动的模拟效果非常好。 开放世界的局限性: 对于像社交媒体或复杂的购物网站这类高度开放的环境,LLM 仍需要更多的训练数据和更大的模型参数才能实现高质量的模拟。 真实观察的修正: 实验显示,如果在 LLM 模拟器中加入少量来自现实世界的真实观察数据,模拟的质量会显著提升。 对 AI 行业的意义 加速 AI 智能体进化: 这种方法让 AI 智能体可以在几秒钟内完成数千次的虚拟实验,极大加快了学习速度。 降低训练门槛: 开发者不再需要搭建昂贵的物理实验室,只需要调用 LLM 接口就能创建一个“训练场”。 2026 年的趋势: 这预示着 2026 年及以后,“自主智能体”将成为 AI 发展的核心,而这种“基于模拟的学习”将是通往通用人工智能(AGI)的关键一步。 总结 该研究证明,LLM 不仅仅是聊天机器人,它们可以演变成复杂的“数字世界创造者”。在这个虚拟世界里,新一代的 AI 智能体可以安全、低成本地反复磨练技能,最终再将学到的能力应用到现实生活和工作中。 ( 根据海外媒体编译 )

1 个月前

Nova 2是亚马逊于2025年12月在re:Invent 全球大会上推出的新一代基础模型家族,共包含4款模型,均需通过Amazon Bedrock平台使用,兼顾行业领先的性价比与多场景适配性,具体介绍如下 : 1. Nova 2 Lite: 主打快速、高性价比的日常推理任务,可处理文本、图像和视频输入并生成文本。能通过调节“思考”深度平衡智能、速度与成本,适合客服聊天机器人、文档处理等场景。在基准测试中,它对标Claude Haiku 4.5、GPT - 5 Mini等模型,多数项目表现持平或更优。 2. Nova 2 Pro(预览版): 是该家族中智能度最高的推理模型,可处理文本、图像、视频和语音输入并生成文本。适配代理编码、长期规划等复杂任务,还能作为“教师模型”向小型模型传递能力,在与Claude Sonnet 4.5、Gemini 2.5 Pro等主流模型的对比中,多项基准测试表现出色。 3. Nova 2 Sonic: 专注端到端语音交互的模型,能实现类人化实时对话。它支持多语言与丰富音色,拥有100万token上下文窗口,可支撑长时交互,还能与Amazon Connect等语音服务、对话框架无缝集成,适配客服、AI助手等语音场景。 4. Nova 2 Omni: 业内首款统一多模态推理与生成模型,可处理文本、图像等多种输入,还能同时生成文本和图像。它能一次性处理海量多格式内容,比如数百页文档、数小时音频等,适合营销素材一站式制作等需要整合多类信息的场景。 这4款模型均具备100万token上下文窗口,且内置网页查找和代码执行能力,能保障回答的时效性与实用性 。

2 个月前

LoRA(Low-Rank Adaptation)是一种对大模型进行“轻量级微调”的技术。

2 个月前

Gemini 3 标志着AI模型从“增量优化”向“范式转变”的重大跃进。

3 个月前

Alice AI:俄罗斯搜索引擎Yandex推出的人工智能助手 从日常任务到城市生活,Yandex的Alice AI正在重新定义人与机器的互动方式。 在2025年10月28日的“Alice,what‘s new?”大会上,俄罗斯科技巨头Yandex推出了全新升级的Alice AI——一个强大的通用神经网络,能够帮助用户在聊天中解决几乎任何任务。 这项技术代表了过去几十年聊天机器人从简单模式匹配到智能交互的演进历程。Alice AI不同于传统的规则驱动聊天机器人,它基于最先进的生成模型,不仅能理解复杂请求,还能主动协助用户完成从信息查询到实际行动的全流程任务。 01 从ELIZA到Alice AI,技术革命的演进历程 聊天机器人的发展始于20世纪60年代,当时麻省理工学院教授魏岑鲍姆发明了世界上第一个聊天机器人ELIZA,它通过模式匹配和替换方法来模拟对话。 受到ELIZA的启发,理查德·华莱士博士在1995年开发了ALICE系统(Artificial Linguistic Internet Computer Entity)。 ALICE采用启发式模式匹配的对话策略,并支持基于人工智能标记语言(AIML)的规则定义。 这一系统在人工智能领域获得了高度认可,在2000年、2001年和2004年三次获得洛伯纳奖(Loebner Prize)。 然而,传统的ALICE系统仍然依赖于预设的模板和规则,需要大量人力进行设计和制定。 Yandex的Alice AI则代表了技术演进的新阶段,它不再局限于规则驱动,而是基于大规模训练的神经网络,具备真正的理解和生成能力。 02 多模态架构,Alice AI的技术内核 Alice AI由三个核心模型共同驱动,构成了其多功能的技术基础。 Alice AI LLM负责处理语言相关的任务,包括回答问题、生成文本和逻辑推理。 Alice AI ART专注于视觉内容生成,能够根据文本描述创建图像和视频内容。 Alice AI VLM作为视觉语言模型,专精于图像分析、理解和与图像相关的任务解决。 这一模型家族将继续扩展,例如图像编辑模型即将推出。 Alice AI支持多种交互方式,包括文本输入、语音对话和实时摄像头交互。 用户可以通过手机摄像头获取实时视觉分析,使Alice AI能够成为识别物体、解释场景的随身助手。 03 四大应用场景,从聊天到实际行动 Alice AI的能力体现在多个实际应用场景中,使其成为用户日常生活的有用伙伴。 智能对话与文件处理:Alice AI可以处理各种类型的文件(DOC、DOCX、PDF、TXT),从中提取关键信息并生成清晰的报告。 它能够进行复杂问题的推理分析,提供深思熟虑的结论而不仅仅是快速回答。 视觉识别与创作:通过图像识别技术,Alice AI可以读取照片中的文本(如收据),识别物体,并提供即时视觉数据分析。 用户也可以请求生成图像或动画照片,用于社交媒体内容、标志设计或生日卡片制作。 浏览器集成与网页交互:Alice AI将很快深度集成到Yandex Browser中,能够利用活动标签页中的信息(无论是文本文档还是视频)来回答问题。 例如,用户可以直接询问一个500页的PDF报告中是否包含6月的销售数据,或者询问关于黑洞视频中讲师提到的内容。 城市服务与AI代理:Alice AI即将帮助城市居民预订出租车、安排送货、订购食物或杂货。 当用户提出请求时,AI代理会分析需求,确定能够处理任务的服务,并连接相应的代理——出租车、食品、 Lavka或送货。 04 “我的记忆”,前瞻性功能重新定义个人助手 Alice AI即将推出的“我的记忆”(My Memory)功能,将更进一步改变用户与AI的互动方式。 这一功能让Alice AI能够将用户随意思考的想法和想法转化为待办事项列表、购物清单、笔记和提醒,所有这些都直接呈现在聊天界面中。 用户可以在行动中向Alice AI口述任务,它会记住所有内容,进行组织,并在适当时机提醒重要事项。 Yandex还宣布了搭载Alice AI的可穿戴AI设备,使用户无需智能手机即可随时记录想法和想法。 这些设备将专注于“我的记忆”服务,让用户能够随时随地通过语音与Alice AI交互。 05 对比传统聊天机器人,Alice AI的突破 与传统聊天机器人相比,Alice AI在多个方面实现了技术突破。 传统聊天机器人如ALICE主要依赖于启发式模式匹配和AIML规则,需要大量人工编写的模板。 而Alice AI基于大规模训练的神经网络,能够理解更复杂的查询并生成更自然的回应。 传统系统多数仅限于文本对话,而Alice AI提供多模态交互,包括文本、图像、视频和语音。 最显著的进步在于,传统聊天机器人主要用于信息查询或简单任务,而Alice AI能够通过AI代理执行端到端的实际任务,从信息收集到最终结果。 从简单的模式匹配到复杂的多模态交互,从回答问题到执行任务——Alice AI代表了聊天机器人技术的又一次飞跃。 随着AI代理和“我的记忆”功能的推出,Alice AI正逐步从一个对话工具演变为一个能够理解、预测并满足用户需求的真正个人助手。 技术专家指出,未来的聊天机器人将不再局限于回答问题的角色,而是成为人类与数字设备交互的重要桥梁。 Alice AI正是这一趋势的领先代表,它正在重新定义我们与技术共存的方式。

3 个月前

DeepSeek OCR 介绍 DeepSeek OCR 是由中国 AI 公司 DeepSeek AI 于 2025 年 10 月 20 日发布的开源视觉语言模型(VLM),旨在探索“光学上下文压缩”(Contexts Optical Compression)的创新范式。它不是传统的 OCR(光学字符识别)工具,而是将视觉编码视为文本信息的压缩层,帮助大型语言模型(LLM)更高效地处理长文档、图像和多模态数据。 该模型的灵感来源于“一图胜千言”的理念,通过将文本转化为视觉表示,实现显著的令牌(token)减少,同时保持高准确性。 核心创新与架构 DeepSeek OCR 的核心思想是将文本作为图像处理,从而实现高效压缩: 视觉-文本压缩:传统 LLM 处理 1000 字文档可能需要数千个文本令牌,而 DeepSeek OCR 通过视觉编码器将图像压缩为更少的视觉令牌(可减少 7-20 倍),然后解码回文本。测试显示,它能保留 97% 的原始信息。 双阶段架构: DeepEncoder:视觉编码器,负责图像处理,包括文档、图表、化学分子和简单几何图形。它基于先进的视觉模型(如 Vary、GOT-OCR2.0 和 PaddleOCR 的灵感),高效提取特征。 DeepSeek-3B-MoE:解码器,使用混合专家模型(MoE,激活参数仅 5.7 亿),生成文本输出。整个模型大小约为 6.6 GB,运行速度快、内存占用低。 多功能扩展:除了基本 OCR,它支持解析图表(生成 Markdown 表格和图表)、化学公式、几何图形,甚至自然图像。深解析模式(Deep Parsing Mode)特别适用于金融图表等结构化数据。 该模型在 OmniDocBench 等基准测试中达到了端到端模型的 SOTA(最先进)性能,优于 MinerU 2.0 和 GOT-OCR2.0 等更重的模型,同时视觉令牌使用最少。 它还支持 vLLM(虚拟 LLM 推理引擎),便于批量处理。 优势与应用场景 效率提升:减少计算成本,适合处理长上下文(如聊天历史或长文档)。例如,将旧对话“低分辨率”存储为图像,模拟人类记忆衰减机制。 实用性:在 OCR 之外,它能处理复杂视觉任务,如从图像中提取结构化数据,而非简单文本复制。 开源与易用:模型托管在 Hugging Face(deepseek-ai/DeepSeek-OCR),支持 PyTorch 和 CUDA。GitHub 仓库提供完整代码和示例。 局限性:作为实验性模型,对简单矢量图形解析仍有挑战;输出有时可能出现幻觉(如中文符号混入英文响应)。 如何使用(快速入门) 安装依赖:克隆 GitHub 仓库(git clone https://github.com/deepseek-ai/DeepSeek-OCR.git),安装 Transformers 和 vLLM。 Python 示例(使用 Hugging Face): from transformers import AutoModel, AutoTokenizer from PIL import Image import torch model_name = 'deepseek-ai/DeepSeek-OCR' tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True) model = AutoModel.from_pretrained(model_name, trust_remote_code=True, torch_dtype=torch.bfloat16).cuda().eval() # 加载图像 image = Image.open("your_image.png").convert("RGB") # 提示(prompt) prompt = "<image>\nFree OCR." # 或其他任务提示,如 "<image>\nParse chart." inputs = tokenizer(prompt, return_tensors="pt").to(model.device) inputs["image"] = image # 添加图像 with torch.no_grad(): outputs = model.generate(**inputs, max_new_tokens=512) print(tokenizer.decode(outputs[0], skip_special_tokens=True)) 这将从图像中提取并输出文本。 DeepSeek OCR 代表了 OCR 从“文本提取”向“多模态压缩”转型的趋势,对于 AI 研究者和开发者来说,是一个值得关注的开源工具。

Minimax(海螺AI)已由大模型名Minimax替换原海螺AI。现海螺AI为Minimax视频生成产品名。

海螺AI